Le tournant cybernétique

Le mot « cybernétique » charrie avec lui quantité de fantasmes et de représentations en tout genre – ordinateurs, informatique, robots, nouvelles technologies en général. Le but de ce cours est Triple. Il s’agira en premier lieu de dissiper cette confusion en répondant précisément à la question « Qu’est-ce que la cybernétique ? ». Une fois ce point établi, nous essaierons de situer la cybernétique par rapport aux sciences de l’époque. Enfin, nous essaierons de dégager quelques uns des enjeux culturels qui entourent la naissance et le développement de la cybernétique.

Introduction

Le mot « cybernétique » charrie avec lui quantité de fantasmes et de représentations en tout genre – ordinateurs, informatique, robots, nouvelles technologies en général. Le but de ce cours est triple. Il s’agira en premier lieu de dissiper cette confusion en répondant précisément à la question « Qu’est-ce que la cybernétique ? » via la lecture des textes fondateurs de N. Wiener. Il nous faudra comprendre la définition qu’il en donne, à savoir qu’elle est « la théorie du contrôle et de la communication, aussi bien chez l’animal que dans la machine ». Pamis les autres enjeux du cours, on essaiera de situer la cybernétique par rapport aux sciences de l’époque : quels problèmes vient-elle résoudre et quel nouveau paradigme scientifique propose-t-elle ? Peut-on parler d’une science cybernétique ? Et aussi de dégager quelques uns des enjeux culturels qui entourent la naissance et le développement de la cybernétique : de l’usage militaire des débuts au pacifisme profond de l’après guerre ; le rapport entre humains et machines ; l’usage de la cybernétique au-delà de son domaine de départ déjà très vaste.

Avant de me lancer, je veux expliquer deux raisons pour lesquelles il me semble important de parler de cybernétique aujourd’hui : le rapport qu’elle entretient avec notre présent ; l’importance de la relation entre science et technique dont la cybernétique témoigne.

La cybernétique aujourd’hui ?

Le problème, c’est que je ne peux pas déplier tout ça en un seul cours, c’est d’ailleurs pour cette raison qu’il y a un petit groupe, héhé. Donc je me concentre sur le principal : la cybernétique, ce que c’est, quelles sont les notions principales qu’elle met en avant, plutôt que ce qui l’entoure. Avant de dire sur quoi je vais me concentrer plus particulièrement dans la cybernétique, j’aimerai dire pourquoi j’en parle, pourquoi ça me paraît intéressant, voire indispensable.

La raison est simple : il semblerait que notre monde soit en grande partie façonné par la cybernétique. Ici, je me contente de reprende les mots de Mathieu Triclot, qui a fait sa thèse sur « le moment cybernétique » et qui écrit :

1. « L’histoire de la cybernétique du début des années 40 à la fin des années 50 constitue l’histoire secrète d’une partie de notre présent, la source d’une manière de décrire le monde, d’un ensemble d’expériences et de positions subjectives qui sont encore les nôtres. » (Triclot)

Mais quel est exactement cet ensemble d’expériences et de positions subjetives dont il parle ? Voici un autre extrait :

2. « Le deuxième trait qui distingue la cybernétique est sans doute que celle-ci se présente à nous comme une science qui a échoué, ou dont le travail a été présenté comme un échec par ses successeurs. Nous avons affaire là à ce qui peut bien appraître comme une énigme. Par un côté, la cybernétique constitue une réussite extraordinaire, dans la mesure où ses concepts ont connu une diffusion inégalée. Nous vivons dans un monde qui a été façonné en partie par la cybernétique. Nous sommes les héritiers des cybernéticiens, chaque fois que nous prenons place devant un ordinateur, non seulement parce que nos machines doivent leur architecture à Von Neumann, mais aussi parce que la cybernétique a exprimé avec force l’idé d’une humanité vivant parmi les machines, dans un univers de communication généralisée. Nous devons donc à la cybernétique non seulement tout un ensemble d’artefacts, mais aussi des manière d’habiter en sujets au sein de ces mondes d’objets. Et pourtant, la cybernétique a, par un autre côté, échoué de a à z. Cette science, à qui nous devons tant, n’a jamais réussi à se stabiliser sous la forme d’une discipline autonome, possédant ses propres lieux institutionnels et programmes de recherche. Nous vivons dans un monde cybernétique, mais sans cybernétique, d’une cybernétique diffuse et dispersée, souvent fort éloignée du projet original »

Mathieu Triclot, Le moment cybernétique, p.9

On se demandait quelles étaient les expériences et positions subjectives : il évoque l’usage des ordinateurs, mais aussi l’humanité vivant parmi les machines et l’univers de communication généralisé. Ce sont effectivement des aspects important de la cybernétique qu’on va tenter d’élucider après. Concernant l’échec de la cybernétique qu’il évoque, je ne vais pas y consacrer une partie plus tard, alors j’en dis trois mot maintenant. Comme il l’explique la cybernétique ne s’est pas constituée en un corps de doctrines bien établies, en une science ou une discipline à part entière.

C’est important pour dissiper quelques erreurs possibles : quand on parle de la cybernétique historiquement, sans parler du contenu, on parle en fait d’un concept associé à un mouvement de pensée d’un type orginal. Original parce que les quelques scientifiques qui se reconnaissaient là-dedans se retrouvaient surtout lors de conférences interdisciplinaires, une ou deux fois par an, entre 1942 et 1953, pour faire large. D’abord aux États-Unis, puis en Europe, et, plus tard, un peu au Chili ou en URSS. Donc vous avez des gens, des physiciens, mathématiciens, biologistes, neurologues, psychologues, sociologues, etc, qui se retrouvent lors de petites sessions de travail, de conférences, de colloques et qui font exister ce nouveau courant. Le mot « cybernétique » apparaît en 1948 avec la publication du livre de Wiener La cybernétique. Information et régulation dans le vivant et la machine. Mais certaines idées étaient présentes avant et l’une des premières rencontre interdisciplinaire eu lieu en 1942. J’ai mis dans la bibliographie quelques dates qui sont de spoints de repères historiques très rudimentaires sur les débuts de la cybernétique aux États-Unis. Mais je les commente pas, c’est just epour celles et ceux que ça intéresse. C’est important surtout pour se rendre compte de quoi on parle : une suite de conférences, de rencontres, de textes, et tout ça explose vers 53.

Le rapport entre sciences et techniques

Venons-en au deuxième aspect du texte de Triclot qui m’intéresse : l’idée d’un monde cybernétique sans cybernétique. Triclot le dit d’un point de vue très concret : les cybernéticiens n’existent plus, il n’y a pas de discipline ou d’école cybernétique, etc. Mais j’aimerai interpréter ça un peu différemment, à partir d’une nouvelle citation d’un des théoriciens du rôle de l’ordinateurs, notamment personnel, au tournant des années 1990, Mark Weiser :

3. « Les technologies les plus abouties sont celles qui disparaissent. […] Elles se tissent dans la trame de notre quotidien jusqu’à s’y fondre complètement »

Et donc c’est aussi en ce sens là qu’on vit dans un monde cybernétique sans cybernétique : elle a réussi à se faire oublier, en quelques sortes, à disparaître ou à se fondre dans notre quotidien, nos « expériences et positions subjectives » comme dirait Triclot. Autrement dit, elle est devenue une espèce d’évidence, au moins sous ses formes les plus caricaturales (ordinateur, information, communication). C’est cette évidence, ou ces évidences, que j’aimerai redécouvrir et questionner pendant ce cours. Travailler les notions de base de la cybernétique pour montrer d’où elles sortent, qu’est-ce qu’elles charrient comme idées, comme nouveauté et qu’est-ce qu’elles changent dans notre monde.

C’est le dernier aspect sur lequel j’insiste dans cette introduction : le lien entre science et technique. C’est l’un des enjeux annoncé de cette année sur la science : en quoi les sciences ne participent pas seulement d’une entreprise de connaissance du monde, de savoir plus ou moins précis ou objectif, mais aussi d’un processus de transformation du monde. Or, avec la cybernétique, c’est tout particulièrement le cas :

4. « La mention du caractère phénoménotechnique de la cybernétique est une invitation à ne pas se restreindre à la dimension de la seule théorie. La cybernétique n’est pas simplement affaire de discours, mais aussi de pratiques, de machines et de dispositifs. […] La cybernétique illustre cette dimension performative des représentations scientifiques. Voici une science qui n’a jamais eu simplement pour objet de représenter le monde, mais de le transformer et de produire un monde à son image. La cybernétique manifeste un type d’alliance entre la théorie et la pratique, la représentation et l’intervention, qui ne peut être esquivé en ce cas, et qui est sans doute un des traits déterminants des sciences contemporaines. »

Mathieu Triclot, Le moment cybernétique, p.8

Ce qui m’intéresse ici, c’est l’idée que la cybernétique, et les « sciences contemporaines » plus largement, ont un rapport direct avec les techniques et la transformation, voire même la création du monde qu’ils analysent. Il y a plusieurs raisons à ça : d’une part la participation active qu’on demande aux scientifiques pour les efforts de guerre : leurs recherches sont directement appliquées ; mais aussi le fait que leurs recherches portent, entre autre, sur des machines capables de calculer, d’effectuer des opérations intellectuelles. Donc : on a des machines, très concrètes, qui calculent, communiquent, etc. D’où le fait que la pensée soit d’emblée accouplée à un univers technique. On peut même aller plus loin et dire, avec Jean-Claude Beaune, que (texte 5) « une nouvelle révolution copernicienne s’amorce : le centre de gravité du monde n’est plus l’homme, mais la machine ». Je ne rentre pas trop maintenant dans l’interprétation de cette phrase, mais je signale la possibilité d’interpréter le tournant cybernétique avec les mêmes termes que la dernière fois : la révolution copernicienne. Pas dans le sens où il y a des idées aboslument neuves, mais plutôt dans un changement de point de vue, et un changement qui nous dérange forcément puisqu’il n’est pas humain, il s’agit de celui des machines.

Voilà pour les enjeux et les intérêts que comporte à mon avis le travail sur la cybernétique.

Plan

Mais venons-en aux définitions, et à la cybernétique en elle-même. Norbert Wiener, celui qui créé le terme, écrit en 1948 : (6) « Ainsi, il y a déjà quatre ans, le groupe de savants réunis autour de Rosenblueth et moi-même était devenu sensible à l’unité essentielle de l’ensemble des problèmes centrés sur la communication, la commande, la mécanique satistique, tant dans la machine que dans le tissu vivant. D’un autre côté, nous étions embarassés par le manque d’unité dans la littérature scientifique concernant ces problèmes, par l’absence de terminologie commune, et plus simplement d’un nom unique pour désigner le domaine. Après maintes réflexions, nous avons conclu que toute terminologie existante s’inscrivait trop dans une discipline ou une autre pour servir comme le devrait le futur développement de ce domaine ; et ainsi qu’il arrive souvent aux scientifiques, nous avons dû inventer une expressoin néogrecque artificielle pour combler ce vide. Nous avons décidé de donner à la théorie entière de la commande et de la communication, aussi bien chez l’animal que dans la machine, le nom de cybernétique, formé à partir du grec kubernetes ou pilote. En choisissant ce terme, nous voulons reconnaître que le premier article significatif sur les mécanismes de rétroaction est un article sur les gouvernails, publié par Clerk Maxwell en 1868, et que gouvernail provient d’une corruption latine de kubernetes. Nous souhaitons aussi rappeler que les appareils de pilotage de navire sont l’une des formes les plus anciennes et les plus perfectionnées de mécanisme de rétroaction. »

Plusieurs choses. D’abord on constate qu’il met un mot sur des recherches qui existent déjà, qu’il a développé avec d’autres. Ensuite, ce qui le préoccupe ici c’est d’unifier le champ de recherches en question, de trouver un vocabulaire commun. Aussi, qu’il est question de dépasser le cloisonnement disciplinaire. Puis vient la définition du mot cybernétique, ce à quoi il correspond : « la théorie entière de la commande et de la communication, aussi bien chez l’animal que dans la machine ». La suite de la citation explicite un peu le mot « commande », qui désigne non pas les ordres ou le gouvernement au sens politique qu’on pourrait entendre directement, mais plutôt les « mécanismes de rétroaction » associés en particulier aux gouvernails, qui permettent d’orienter les navires. Il précise bien la racine du mot, qui vient du grec kubernetes, qui se rapporte au pilote et à l’action de gouverner, de tenir le gouvernail. Je reviendrai sur tout ça, mais voyons la définition, que j’ai mise en gras. Je pense qu’on peut s’arrêter sur trois éléments, qui nous serviront de guides pour les parties de l’exposé.

D’une part la commande, d’autre part la communication et enfin le fait que la théorie s’applique aussi bien aux vivant qu’aux machines.

I. Il utilise ici le mot communication mais il est parfois remplacé par information, comme c’est le cas dans le titre de l’ouvrage traduit en français. Donc la cybernétique prétend théoriser la communication ou l’information. Ici on sent bien qu’on a à faire à une des évidences de l’époque actuelle. Certains parlent de société de l’information ; on évoque souvent l’informatique, qui vient de la contraction entre information et automatique, etc. On est donc exactemnet dans le domaine des évidences, des expériences et positions subjectives propres à notre modernité qu’il nous faut questionner. Qu’est-ce que cette information dont parle Wiener ?

II. Ensuite, il parle de commande, qu’il précise un peu avec la notion de mécanisme de rétroaction et de gouvernail. La commande désigne la manière dont on dirige un appareil quelconque et les mécanismes qui permettent d’effectuer ces opérations. Dans une deuxième partie, on se concentrera sur cette notion de commande ou de régulation.

III. Enfin, le lien entre vivants et machines. Les deux notions ci-dessus (communication et commande) valent de façon homogène lorsque l’on parle des vivants ou des machines. Il y a plein d’exemples dans le corpus cybernétique mais je choisi de me focaliser sur l’un d’entre eux, qui me semble être le plus important : l’analogie entre le cerveau et l’ordinateur.

I. La naissance de l’information

On pourrait dire que le matériau de base de la cybernétique est l’information. Pour essayer de cerner cette notion et son apparition, il faut essayer de la replacer un peu dans son contexte technique, historique et scientifique.

Quelques repères historiques

Du point de vue technique, les moyens de communication avaient explosé au milieu du 19e siècle avec l’apparition du télégraphe (optique fin 18e et électrique vers 1830), puis du téléphone (1876) et de la radio (1895-1896). Un des enjeux était de parvenir à franchir des distances toujours plus grandes avec ces moyens de communication : relier les côtes est-ouest des usa par exemple, communiquer d’un côté à l’autre de l’Atlantique, etc. Les usages sont variables : politique (le premier télégraphe relie Paris et Lille pour pouvoir faire la guerre au nord aux ennemis de la révolution ; plus largement, communiquer sur l’ensemble d’un territoire permet de donner des ordres et d’assurer l’exercice du pouvoir centralisé de manière plus efficace) ; économiques (commerce, début de la finance, etc) ; culturels, etc.

Avec la première guerre mondiale, le besoin en communications fiables explose, et l’entre deux guerre fut un moment de grande avancée dans l’ensemble des domaines de la communication. Mais surtout, vers la fin du 19e émerge un nouveau fonctionnement du capitalisme, qui deviendra par la suite décisif : la science se met à contribuer de manière fondamentale aux divers processus productif. Les nouvelles inventions ne dépendent plus de personnes ingénieuses un peu touche à tout, comme c’était encore le cas avec la machine à vapeur de James Watt. Dorénavant, des armées de scientifiques parmi les plus doués travaillent à temps plein pour les grandes entreprises, en particulier dans le domaine des Télécoms, où les fameux laboratoires Bell, fondés en 1925 dans le New Jersey, sont responsable de la plupart des avancée majeures (ils ont déposé des centaines de brevets). C’est intéressant pour notre thème de l’année : les sciences se mettent au service de l’industrie et d’une manière systématique. L’organisation du travail permet à des scientifiques de travailler sur des domaines très pointus en vu d’améliorer toujours plus les produits, économiser les coûts, etc. J’insiste ici sur les télécoms parce que c’est ce qui m’intéresse pour la suite mais c’est vrai pour la plupart des secteurs. Et en termes socio-culturel, c’est très important : la séparation entre le travail manuel et le travail intellectuel devient une réalité à partir de ce moment là. Les gens qui font quelque chose, qui éxecutent des tâches, ne sont plus forcément capable de comprendre ce qu’ils font, d’avoir le savoir, la science de ce qu’ils fabriquent. Je reviendrai un peu là-dessus mais retenons ce point.

La deuxième guerre mondiale accélère l’ensemble des processus que je veins d’évoquer. Aux États-Unis, tous le smeilleurs scientifiques sont mis à contribution pour l’effort de guerre. L’ensemble de la recherche se réorganise dès 1940 pour que tout le monde se mette à travailler sur des sujets qui permette de gagner en puissance guerrière. Du point de vue des télécommunications, les enjeux sont énormes : il faut intercepter les informations ennemies et les décrypter ; parvenir à communiquer avec ses alliés de manière sécurisée ; pouvoir donner des ordres à distance, et notamment aux avions qui prennent de plsu en plus de place. Je n’en parlerai pas ici mais l’exemple le plus flagrant est évidemment celui de la bombe atomique : dans le cadre du projet Manhattan, tous les plus grands scientifiques sont regroupés dans le secret le plus absolu durant plusieurs années pour développer la bombe atomique. Mais sans même parler de la bombe, ces efforts d eguerre et la réorganisation de la recherche a stimulé plusieurs chercheurs à faire des rapprochements interdisciplinaires. Et c’est dans ce contexte que la cybernétique fait ses premiers pas.

Les origines scientifiques de la notion d’information

Avant la guerre, plusieurs champs de la recherche et du savoir commencent doucement à se diriger vers le mise au point de la notion d’information. Je parle rapidemment ici de 3 origines dans le champ des sciences et des techniques, parce qu’elles sont intéressantes à chaque fois pour des raisons différentes. La physique, les mathématiques et les télécommunications.

- L’information comme quantité physique. En physique théorique, et en particulier en thermodynamique, la discipline qui s’occupe des changements de température, on travaille beaucou sur une notion un peu mystérieuse pour le grand public, qui s’appelle l’entropie. Je ne rentre pas trop là-dedans parce que c’est compliqué. Au départ, la notion désigne simplement le fait que de la chaleur ne peut pas passer directement d’un corps froid à un corps chaud ; autrement dit, la chaleur va plutôt du chaud vers le froid et se dissipe. Au départ l’entropie désigne plutôt cette inéluctabilité de la dissipation de la chaleur. Certains en ont tiré assez vite l’idée d’une mort thermique de l’univers : au bout d’un moment, toute la chaleur se sera dissipée. Mais très vite, certains physiciens ont dit que l’entropie pouvait aussi s’interpréter comme une mesure du désordre d’un système thermodynamique. Et donc, la croissance de l’entropie, la tendance de tous les systèmes vers l’entropie, au lieu de s’interpréter uniquement comme dissipation de la chaleur, a pu aussi s’interpréter comme une évolution inéluctable vers des états de plus en plus désordonnés. Quel est le rapport avec l’information ? Eh bien pendant l’entre-deux guerres, un physicien qui s’appelle Léo Szilard (important par ailleurs car c’est lui qui dit à Einstein qu’il faut se mettre à travailler sur la bombe A avant les allemands) a doucement commencé à dire qu’on pouvait qualifier l’information comme l’inverse de l’entropie. Mais attention ici l’information n’a rien à voir avec la chaleur : si elle est l’inverse de l’entropie, c’est en tant qu’elle mesure une quantité d’ordre, là où l’entropie désigne une quantité de désordre.

- L’information comme notion statistique

Là je rentre encore moins dans les détails si possible, juste le temps de donner un nom important, celui de Ronald Fisher. Je précise qu’il est un eugéniste convaincu de l’inégalité essentielle entre les races et les humains en général. Et ses travaux s’en trouve largement imprégnés : il travaille sur la génétique des populations (dont il est l’un des fondateurs), à partir de banques de données issues de l’agronomie. Les statistiques sont pour lui un moyen d’analyser la sélection naturelle, son évolution et éventuellement les interventions à faire sur elle. C’est important aussi pour l’information parce qu’elle va de pair, chez Fisher, avec l’idée de sélection.

Chez lui, une statistique doit résumer l’information contenue dans un échantillon, notamment pour être exhaustive. À partir de là il trouve dès 1925 une formule de la quantité d’information relative à un échantillon d’observation. Au départ l’information est contenue dans les données brutes et une statistique doit la découvrir, ensuite elle devient une valeur constante calculée à partir d’un échantillon. Il fait également le lien avec l’entropie et la question de la réversibilité : alors que les processus bijectifs et réciproques sont réversibles, les stats ne le sont pas : on ne peut pas reconstruire l’échantillon à partir d’une statistique : « il peut y avoir une perte de l’information mais jamais un gain » (38).

- L’information dans les télécommunications

C’est dans ce domaine qu’apparaît ce qu’on appelle la théorie de l’information. Les autres domaines ne sont d’ailleurs pas toujours mentionnés. C’est aussi dans ce domaine que les applications sont les plus directes. L’enjeu : améliorer le télégraphe et les moyens de communicaiton en général. L’impératif est d’abord économique : il s’agit de communiquer plus, plus loin, plus vite à moindre coût.

Lacan écrit dans son séminaire (7) : « Il s’agit de savoir quelles sont les conditions les plus économiques qui permettent de transmettre des mots que les gens reconnaissent. Le sens, personne ne s’en occupe »

2 choses : communiquer à moindre coût et l’absence de sens. On verra pourquoi avec ce qui suit.

Reprenons les télécoms où on les avait laissés juste au-dessus. Télégraphe et téléphone sont des réseaux passifs : les signaux ne sont pas modifiés une fois envoyé. Et le médium (l’onde électrique) apparaît comme la continuité du message (l’onde de la voix) poursuivis par d’autres moyens (un câble), pour le téléphone par exemple.

Problème : les distances peuvent atténuer les signaux. Les fils doivent être fins (ce qui atténue la résistance) et il n’y a qu’un seul signal par fil. Fragilité, plein de fils partout, c’est cher.

Solution 1 : amplification de la puissance du signal. Or les fils sont fragiles. Mieux : mettre des répéteurs, qui répètent le signal à interval régulier pour lutter contre le bruit et l’atténuation.

Solution 2 : mise en forme des signaux (étude mathématique de l’ondulation, qui permet de mettre en forme des signaux qui s’atténuent le moins possible). Le signal n’est plus un courant électrique mais une onde. Modulation et multiplexage (plusieurs signaux sur une ligne) améliorent le signal. Surtout, on se met à décorréler le signal, le message, comme une réalité sur laquelle on a prise, du médium. C’est important de saisir ça : on se dit, ce qui importe, ce n’est pas frocément l’impulsion électrique, mais l’onde qui en découle, sa forme et les moyens qu’on a de la modifier.

Solution 3 : codage des signaux. Mettre les séquences les plus courtes avec les lettres les plus utilisées. Pour ça, il faut vraiment traiter l’information comme une réalité à part.

Ces trois champs forment l’ossature de la cybernétique : les amplificateurs mènent plus tard à la notion de feedback négatif (on y viendra en deuxième partie) et le traitement du signal et du codage à la notion d’information. Outre les dimensions physiques des lignes, il s’agit donc de travailler sur l’information elle-même pour la mesurer.

Dans l’entre-deux guerres, plusieurs chercheurs avancent dans ces directions. Il leur manque plusieurs étapes pour arriver à une réelle théorie mais ils ont l’intuition de ne pas se concentrer seulement sur la source d’énergie et de regarder vers la mise en forme des messages en eux-mêmes, traités comme des réalités à part qu’il s’agit de coder le plus efficacement possible.

La théorie mathématique de la communication

La plupart des ingrédients et des pistes de recherche étiaent donc déjà présentes avant la guerre pour isoler un objet qu’on appellera ensuite l’information. Mais il a fallu les recherches de guerre pour accélerer le processus, faire travailler ensemble des matheux et des ingénieurs et aboutir à une théorie à proprement parler. La forme canonique de cette théorie se trouve chez Claude Shannon, ingénieur dans les fameux Bell Labs que j’ai évoqué plus haut. C’est un petit génie qui a bossé sur des outils de détection aérienne et la cryptographie pendant la guerre. Son nom est encore aujourd’hui associé à ce qu’on s’est vite mis à appeler la théorie de l’information.

Son approche se fait par la notion de code : l’information n’est pas un phénomène physique mais un « ensemble structuré de symboles », ou encore, la structure statistique des messages pris dans leur aspect formel, symbolique.

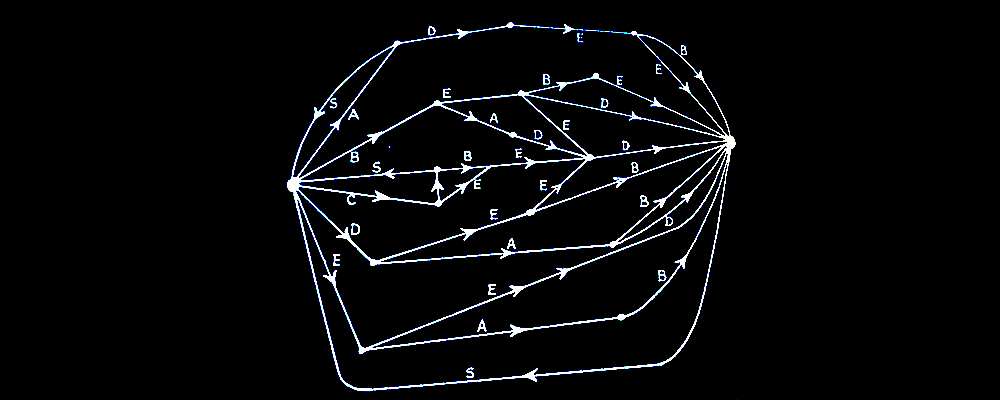

On retient de son article de 48 plusieurs choses et en particulier un schéma de la communication en 5 étapes : Source d’information qui émet le message (lettres, onde, courant) ; transmetteur qui convertit le message en signal adapté au canal de transmission ; bruit de ligne qui brouille le signal pendant le transfert (qui devient un élément essentiel et non plus contingent) ; récepteur qui fait l’inverse du transmetteur ; puis destinataire (humain ou machine).

L’essentiel du travail de l’ingénieur selon Shannon, c’est l’encodage du message, donc l’émetteur, pour résister au bruit et parvenir au destinataire. Ce qu’il trouve, c’est une théorie mathématique de l’encodage en définissant la quantité d’information. D’autres avaient déjà commencer à mesurer des quantités d’information auparavant mais lui donne une théorie et des mathématiques solides qui vont avec. Il en arrive à une formule que je ne détaille pas parce que ça va vous embrouiller mais je l’ai mise dans l’exemplier pour celles et ceux que ça intéresse.

Il donne la formule de la quantité d’information (H), qu’il appelle entropie (sans justifier plus que ça). Pour reprendre les mots de Triclot (8), « La quantité H est une manière d’exprimer la quantité de structure dans un agencement symbolique produit par une source de messages ». On retrouve donc l’idée que l’information est une certaine quantité d’ordre ou de structure.

Retenons seulement quelques aspects de cette quantité d’information. D’abord, plus le nombre de messages possibles est grand, plus l’incertitude du message est grande, plus l’information contenue dans un message est grande. Ensuite, l’intérêt de cette formule, c’est de déterminer des moyens de coder le plus efficacement possible des messages à partir d’une étude statistique poussée de la source qui les émets. Ça semble compliqué mais c’est très simple : si je code des lettre, j’essaye d’associé des codes simples aux lettres qui reviennent beaucoup, pareil pour des mots, etc. Ou encore, Shannon découvre que dans le cas de la langue, il vaut mieux coder des mots entiers (des blocs de lettres) que des lettres seules : on aura besoin de beaucoup moins d’unités élémentaires d’informations, de bits. C’est l’un des autres points importants de cette théorie : il popularise l’usage du bit comme unité élémentaire d’information. Un bit, c’est un choix possible entre un 0 et un 1. Par exemple, pour exprimer l’information contenue par un lancé de pièce de monnaies (pile/face), j’ai besoin d’un bit (0=pile, 1=face). Par contre, si je veux exprimer l’information contenue dans un lancé de dés à 6 faces, il me faudra plus de bits, en l’occurence 3 (voir le calcul en annexe, mais c’est pas important). Par exemple : 1=000 ; 2= 001 ; 3= 010 ; 4=100 ; 5=011 ; 6=111. Avec ce nouvel élément, le bit, l’information acquiert un statut de réalité d’autant plus fort : non seulement il y a des formules mathématiques qui donnent la quantité d’information, mais on peut l’exprimer en une unité, le bit, qui lui donne une sorte de réalité.

Limites :

1) distinction totale entre information et signification : une suite aléatoire de 0 et de 1 peut avoir la même quantité d’information qu’un message signifiant. C’est négligeable du point de vue de l’ingénieur mais problématique quand on essaye de l’appliquer à d’autres domaines (linguistique, etc).

2) le message isolé n’existe pas : l’info est toujours mesurée en fonction de l’ensemble des message possibles d’une source, donc de la structure statistique de la source. Donc la quantité d’info n’est pas une propriété intrinsèque du message individuel, mais plutôt de la source.

3) Les calculs pour coder deviennent grands, on perd du temps au codage. Et : plus le code est efficace, plus les erreurs de transmission ont des conséquences importantes. Il faut donc s’attacher aussi à réduire le bruit (ie la perturbation du signal, qui est traitée par Shannon comme une nouvelle source de message).

3) la construction est abstraite, mathématique, par le haut. Elle tombe si on a pas les bons axiomes (ex : ergodicité de la source).

Pour terminer sur la notion d’information, je précise que Shannon n’est pas le seul à s’y intéresser, même si c’est sa théorie que l’on va retenir comme étant la théorie canonique de l’information. Au sein même de la cybernétique, d’autres approches de l’information ont eu lieu, notamment par Norbert Wiener, qui tombe sur des résultats mathématiques comparables à ceux de Shannon. Ce dernier était tout à fait conscient de la dimension absolument nouvelle de la notion d’information. Une des phrases que l’on cite souvent de lui est la suivante (9) : « L’information est l’information, non matière ni énergie. Aucun matérialisme qui refuse de l’admettre ne peut survivre aujourd’hui ». Cela pose le statut d’existence de cette réalité nouvelle qu’est l’information : Wiener dit qu’elle n’est réductible à rien de ce que l’on connaît déjà, c’est un élément radicalement nouveau qui, à la limite, ne se définit que par elle-même.

Là encore, il y a un enjeu épistémologique intéressant : ont-ils découvert cette réalité nouvelle qu’est l’informatino ou l’ont-ils inventée ? C’est un débat récurrent parmi les scientifiques : est-ce que l’on découvre des lois de la nature indépendantes de nous ou est-ce qu’on les invente ? Dit autrement, c’est le débat entre une position réaliste, qui postule que les entités dont parlent la sicence existent réellement et la position constructiviste, qui énonce qu’on ne connaît que ce qu’on a nous-même construit, qu’il n’y a pas une réalité vraie, ultime, derrière tout ça. Dans le cas de l’information et avant de passer à autre chose, je me réfère à la positionde Mathieu Triclot lorsqu’il écirt :

« Dire que les cybernéticiens ont inventé ou construit l’information n’est pas faux. Avant la cybernétique, on ne pensait pas le monde en termes d’information. Mais la pensée ne fait pas tout à l’affaire. L’idée de construction est trop souvetn associée à une position antiréaliste en philosophie des sciences. Poser que l’information est le résultat d’une construction par la cybernétique ne signifie pas qu’il n’y ait en réalité rien comme l’information, que l’information ne soit qu’un pur jeu de langage superposé au monde indifférent des choses. Si l’information peut être construite, constituée en objet de théoriqe, c’est bien parce que qu’il existe des techniques de l’information, télécommunications ou calcul mécanique, qui font de l’information autre chose qu’un simple objet de discours. L’étude de la cybernétique incite à une forme de réalisme phénoménotechnique. Comme Ian Hacking a pu le dire, à propos des électrons, pourquoi croire qu’il existe quelque chose comme de l’information ? Parce qu’il existe des dispositifs techniques, parce que l’on sait s’en servir, parce qu’on sait la manipuler, parce qu’on dispose au jour le jour d’un répertoire d’opérations banales et standardisées. L’information n’existe pas dans l’éther d’un monde spirituel et idéal, mais dans les méandres d’un univers d’usages et d’artefacts, dans une culture matérielle. »

D’où l’importance du contexte, de la guerre, de la manipulation permanente des notions de messages et de codes (Shannon fait en 1945 une théorie de la cryptographie où l’on trouve toutes les bases de sa théorie de la communication). Il en va de même pour le second concept central de la cybernétique : celui de rétroaction ou de feedback.

II. La notion de rétroaction

Les distinction que j’établis entre information et rétroaction sont un peu artificielles : elles servent surtout à se concentrer sur tel ou tel aspect, mais en réalité tout va ensemble. Ici, on va se pencher plutôt sur les travaux de Norbert Wiener, qui est celui qui a le plus mis en avant l’importance du feedback, mais il a aussi thématisé la notion d’information, en partant d’un point de vue un peu différent de celui de Shannon. On le verra en filigrane mais on essaie de se concentrer ici sur la notion de rétroaction. Pour comprendre ça, on peut revenir rapidemment sur le contexte dans lequel il travail.

Le AA-Predictor (1940)

Mai 1940 : bombardement nazis sur l’Angleterre. Après avoir travaillé juste avant la guerre sur un projet d’ordinateur, il se reconvertit dans l’étude des servomécanismes et de la conduite de tir. Servomécanisme : attention à l’orthographe, ça s’écrit servo et non pas cerveau, ça désigne les mécanismes asservis à un but. On désigne ainsi le (11) « Mécanisme automatique capable d’accomplir une tâche complexe en s’adaptant aux consignes qu’il reçoit », comme par exemple le célèbre régulateur à boule de Watt, qui a fait démarrer la première révolution industrielle. C’est pour ça que le mécanisme est dit asservi : il est asservi à un but, un objectif donné. Les exemples sont multiples, le plus connu est le thermostat : la même machine qui chauffe possède un dispositif de mesure qui lui ordonne de s’arrêter en fonction d’un objectif, d’une commande, fixée à l’avance (s’arrêter à telle température).

Conduite de tir : ça désigne le fait d’ordonner à une machine de déclencher une frappe dans telle ou telle direction. Or, la défense anti-aérienne devient prioritaire à cause des bombardements sur Londres (41 000 morts, 3,75 millions de londonniens évacués). Wiener travaille avec l’ingénieur Julian Bigelow sur un radar, le Anti Aircraft-Predictor. Il s’agit de faire une théorie mathématique de la prédiction pour prévoir le comportement d’un avion et ajuster le tir en fonction. Le problème, c’est de repérer les avions ennemis, de transmettre leur position à un canon et de déclencher le tir de ce dernier. Problème : entre le moment où la position adverse est donnée et le moment où le missile est tiré, l’avion a bougé. Il faut donc intégrer une marge d’erreur. Ou plutôt, il faut intégrer une prédiction de la trajectoire future de l’avion.

Pour ceux que ça intéresse du point de vue des maths, l’opération que l’on fait est de minimiser la différence entre l’observation de l’avion à un moment et l’endroit où l’on prédit qu’il soit au même moment. Cette différence défini en gros l’erreur de calcul, elle désigne simplement l’écart entre ma prédiction et mon observation. L’enjeu, c’est de réduire cet écart à zéro. Ce travail de minimisation se fera sur des bases statistiques, on retrouve les stats, où l’on considère la trajectoire passée de l’avion, mais aussi nos erreurs de prédictions, afin de les minimiser.

Le problème avec tout ça, c’est que sur un champ de bataille, les mesures doivent être très rapides et les instruments dont on dispose génèrent du bruit, c’est à dire du brouillage dans les signaux qui doivent être transmis du pointeur au calculateur puis au canon. En plus, la vitesse des avions étant très rapide, on peut avoir du mal à anticiper la trajectoire future, etc. Enfin, il faut aussi prendre en compte le comportement humain du conducteur de l’avion mais aussi de l’opérateur qui pointe l’avion ennemi (après, cet opérateur sera remplacé par des radars).

Le projet sera abandonné, trop complexe. Mais ce qui importe, c’est le mode de raisonnement.

Il consiste d’abord à analyser les choses en dehors de toute psychologisation : on ne s’intéresse qu’au comportement observable et observé du système pilote-avion pris comme une boîte noire. La seule variable pertinente, ce sont les mesures d’altitude, de vitesse et les séries passées de ces mesures pour en tirer des prédictions. Ces prédictions sont tantôt transmises et interprétées par des machines ou par des hommes, sous la forme d’information et de communication. On voit donc bien en quoi l’information émerge comme l’écrivait Triclot d’un complexe technique, d’un nouveau monde et de nouveaux problèmes techniques. D’ailleurs, il écrit aussi que, (12) « L’information devient chez Wiener un objet universel : ce qui circule entre les hommes et les machines dans un milieu technique, ce que les machines échangent de manière fondamentale, en deçà des transferts énergétique. »

Donc, Wiener et Bigelow, l’ingénieur qui l’accompagne, envisagent tous les phénomènes et tous les problèmes par le même angle : la transmission d’informations d’un point à un autre mais aussi la réduction de l’erreur en fonction d’un but. Cette réduction de l’erreur en fonction d’un but, elle s’applique aux machines, qui doivent tenter d’éliminer le bruit pour pouvoir lire et transmettre des messages fiables, mais elle s’applique aussi aux humains, qui essayent d’estimer et de corriger leurs comportements en fonction d’un but poursuivi. C’est cette opération là, qui peut paraître rudimentaire, de réduction de l’erreur en fonction d’un but, qui donne lieu au concept de rétroaction. La rétroaction désigne une chose toute simple, à savoir le fait qu’une machine puisse réguler son comportement en fonction d’un but prescrit. C’est la même chose que le servomécanisme dont je parlais plus haut. Un schéma d’une rétroaction simple se trouve sur l’exemplier :

À partir de cette notion qui semble anodine, Wiener et son ingénieur continuent de creuser pour aller vers une théorie plus générale.

« Intention, comportement, téléologie » (1943)

Wiener et Bigelow continuent à travailler sur les rapports animal-machine. Rosenblueth intervient ici, physiologiste mexicain rencontré par Wiener dans les années 30. Les deux lui demandent si l’on ne trouve pas un équivalent humain du feedback, c’est-à-dire de rétroaction, notamment à travers des manifestations pathologiques. Rosenblueth dit que oui, il existe des maladies (purpose tremor, tremblement intentionnel) qui résultent d’un feedback excessif, liées à des lésions du cervelet. Elles se déclarent lorsqu’un individu malade veut réaliser une action finalisée : par exemple il veut s’emparer d’un stylo et il se met à trembler beaucoup trop fortement pour pouvoir le faire. Attention, rien à voir avec Parkinson où l’on tremble presque constamment mais où, justement, certaines actions intentionnelles restent parfaitement réalisables (certains affirment même pouvoir réaliser des opérations chirurgicales !).

Donc, ils en déduisent : le comportement finalisé est bien régi par une rétroaction négative, chez l’animal et la machine. Ils font même l’hypothèse que c’est lié au cervelet, qui serait donc l’organe de commande de la rétroaction chez l’homme.

En 1943, ils écrivent ensemble : « Purpose, Behavior and Teleology » (Wiener, Rosenblueth et Bigelow, dans Philosophy of Science). Cette année marque le tournant entre les recherches de guerres et les recherches civiles, tournées plus vers le vivant et avec un aspect philosophique plus fort.

Ils s’intéressent aux comportements actifs, avec but, avec feedback (la sortie est transformée en entrée→ adaptation en fonction du but), prédictif.

J’ai mis la série de distinctions qu’ils effectuent entre les différents types de comportements. On notera que ça ressemble très fort au Sophiste ou au Politique de Platon : la méthode par distinction.

Le cadre est encore behavioriste : c’est du point de vue purement comportemental qu’on peut rapprocher les comportement humains et machinique, sans ouvrir la boîte noire de la fonction, ce qui sera largement fait ensuite (neurones-machines). La fonction désigne ici la manière dont fonctionne l’appareil, machine ou humain, en question.

Je reprends rapidement les distinctions de Wiener, Bigelow et Rosenblueth :

- Actifs (source d’énergie interne : tel moteur, ou tel vivant), non-actif (un objet jeté, qui subit juste l’énergie transmise par un autre) ;

- Intentionnels (ie « orienté vers un but à atteindre » ; exemple : torpille autoguidée) ; non-intentionnels (certains mécanismes comme la roulette, qui vise précisément l’absence de but, la cloche ou encore le fusil). Il admet que le concept d’intention est vague. D’ailleurs, c’est une entorse au behaviorisme de départ, qui normalement ne devrait pas se préoccuper des intentions.

- Téléologiques ou à rétroaction (feedback) : une partie de l’action en sortie ou produite (output) est renvoyée en entrée. Voir le schéma de base que j’ai mis sur l’exemplier : la boucle la plus simple du monde. La rétroaction peut être positive (ex : amplificateur : je reçois un signal, je le multiplie par 2, très utile dans les télécoms) ; mais les auteurs préfèrent se concentrer sur la rétroaction négative, dans laquelle les signaux en sortie sont utilisées pour restreindre l’activité en fonction de la marge d’erreur, comme on l’a vu avec la commande de tir par exemple.

Exemple de comportement sans rétroaction : le coup de langue du crapaud ou du serpent : il a bien un but (attraper une mouche) mais son comportement ne peut pas être révisé en fonction du but au cours du comportement car il est trop rapide ; pas le temps de faire un feedback.

Attention, certaines rétroaction peuvent s’avérer catastrophiques si on ne fait que réguler la régulation : oscillations infinies. Exemple avec des machines mal réglées mais aussi ils reprennent aussi l’exemple du tremblement intentionnel. Et proposent donc que la fonction du cervelet soit « de régler les mécanismes nerveux a rétroaction impliques dans l’activité motrice intentionnelle. » - Prédictifs (ex : le chat qui chasse la souris ne va pas directement sur elle) ou non (ex : certains organismes unicellulaires qui suivent un stimulus sans l’anticiper, ex de la tique qui ne réagit qu’à trois stimuli, etc)

- Prédictifs à différents degrés, ici ils indiquent le fait qu’on peut prendre en compte différentes dimensions pour prédire (ex d’un limier qui suit une piste juste par l’odeur) : pour le tir sur une cible mouvante, il faut prévoir le mouvement de la cible, celui de la flèche, du bras, etc ; on peut aussi imaginer les prédictions sur les prédictions des autres (ex en économie).

Un des enjeux de cette classification selon Wiener, c’est qu’elle permet une analyse comportementale uniforme, applicable à la fois aux machines et aux organismes vivants, malgré leurs différences fonctionnelles. La suite n’arrête pas de le répéter. Enfin, il termine par des considérations philosophiques sur la notion de téléologie, définie ici comme intention réglée par rétroaction. L’idée de téléologie était auparavant associée au concept de cause finale, cf. Aristote. On a rejeté ce dernier parce qu’il impliquait une cause postérieure dans le temps à son effet. Problème : on a jeté la notion d’intention avec. Il propose de ne rien dire sur la cause finale, de la rejeter, mais de repêcher la notion d’intention.

Reste que c’est un behaviorisme hérétique puisqu’il parle des comportements dirigés vers une fin…

« La finalité, ce caractère si singulier des êtres vivants, ne doit plus être considérée comme échappant au mécanisme ou au déterminisme. » (91) vivants et machines sont pris comme des automates à feedback, la différence finalité-mécanisme est obsolète. L’horloge mécanique laisse la place à la torpille qui cherche sa cible (Wiener ne peut pas mentionner le Predictor, classé secret).

Selon eux, texte 15 : « Selon cette définition restrictive, la téléologie [restrictive car on a enlevé l’idée de cause finale et gardé seulement la notion d’intention, de but] n’est pas opposée au déterminisme, mais a la non-téléologie. Les deux systèmes, téléologique et non-téléologique, sont déterministes, du moment que le comportement considéré appartient au domaine où le déterminisme s’applique. »

Donc la cybernétique a l’ambition de dépasser la séparation vivant-machine grâce à cette notion de comportement finalisé, qui a un but et qui peut être régulé en vue de ce but. À partir de cette base un peu étrange, ils continueront de déployer leur analyse dans les conférences et les livres de Wiener.

Cybernetics (1948)

Ce livre, j’en parle juste parce que non seulement c’est là où Wiener invente le terme cybernétique, mais aussi parce que, pour un livre scientifique, avec beaucoup de maths compliquées, c’est un best-seller : plus de 30000 exemplaires vendus en quelques années. En fait, c’est un peu l’explication du nouveau monde que la seconde guerre mondiale a produit, un monde fait de machines et d’hommes où les machines et les technologies ont potentiellement plus d’importance que les humains (cf. la bombe atomique). Dans un tel monde, ce sont les notions de communication et de commande qui deviennent centrales (voir texte 16 : « Si le dix-septième et le début du dix-huitième siècle sont l’âge des horloges, et la fin du dix-huitième et le dix-neuvième siècle l’âge de la machine à vapeur, le temps présent est celui de la communication et de la commande. »), car elles prennent en compte les machines, leur pouvoir immense, et le besoin qu’on a de les réguler. En un certain sens, la cybernétique émane aussi du besoin de réguler les immenses pouvoir générés par la tchnologie et la science pendant la guerre.

En termes conceptuels, il n’apporte pas un grand changement concernant la notion de rétroaction, à part de nouveaux exemples plus détaillés du côté des machines et des phénomènes physiologiques nouveau. Une précision sur la notion de rétroaction volontaire permet de bien fixer le concept : appliquée aux humains, la rétroaction ne doit pas se comprendre comme un contrôle de l’action de chacun de mes muscles, mais plutôt comme une estimation de ma marge d’erreur : « on ne cherche presque jamais à mouvoir tel ou tel muscle, et on ne sait d’ailleurs généralement pas quels muscles doivent être mus pour accomplir une tâche donnée ; on veut, disons, une cigarette. Le mouvement est régulé par une mesure de l’écart selon lequel il n’a pas encore été accompli. »

The human use of humain beings (1950)

Dans son livre à destination du grand public, qui paraît en 1950, Wiener s’autorise à user de la notion de rétroaction de manière plus large, en particulier pour évoquer les phénomènes d’paprentissage (texte 18) : « L’action en retour est la commande d’un système au moyen de la réintroduction, dans ce système, des résultats de son action. Si ces résultats sont utilisés simplement comme données numériques pour la critique et pour le réglage du système, nous obtenons une action en retour simple que connaissent les ingénieurs des commandes. Si, par contre, l’information qui revient en arrière à partir de l’action est capable de modifier la méthode générale et le modèle de celle-ci, nous disposons d’un processus que l’on peut bien nommer apprentissage. »

Aussi, il fait la synthèse entre information et régulation lorsqu’il écrit : « L’information est ainsi le nom du contenu de notre éhange avec le monde extérieur pendant que nous nous ajustons à celui-ci et que nous lui faisons subir le processus de cette adaptation […] vivre effectivement, c’est vivre avec une information adéquate […] le sort de l’information dans un monde typiquement américain est de devenir une chose ayant un prix et qui peut être vendue ou achetée »

Il s’autorise aussi dans ce livre des interprétations plus larges et politiques des notions de communicaiton et de régulation : elles valent aussi à l’échelle de sociétés et de leur organisation. Je ne vais pas trop rentrer là dedans mais c’est l’un des aspects qui a fait couler beaucoup d’encre par la suite : l’idée que la cybernétique soit une science du gouvernement, comme l’indique son nom. cf. Les préoccupation du père Dubarle dès 1948 dans un article du Monde :

« Une des perspectives les plus fascinantes ainsi ouvertes est celle de la conduite rationnelle des processus humains, de ceux en particulier qui intéressent les collectivités et semblent présenter quelque régularité statistique, tels les phénomènes économiques ou les évolutions de l’opinion. Ne pourrait-on imaginer une machine à collecter tel ou tel type d’informations, les informations sur la production et le marché par exemple, puis à déterminer, en fonction de la psychologie moyenne des hommes et des mesures qu’il est possible de prendre à un instant déterminé, quelles seront les évolutions les plus probables de la situation ? Ne pourrait-on même concevoir un appareillage d’État couvrant tout le système des décisions politiques, soit dans un régime de pluralités d’États se distribuant la terre, soit dans le régime, apparemment beaucoup plus simple, d’un gouvernement unique de la planète ? Rien n’empêche aujourd’hui d’y penser. Nous pouvons rêver à un temps où la machine à gouverner viendrait suppléer - pour le bien ou pour le mal, qui sait ? - l’insuffisance aujourd’hui patente des têtes et des appareils coutumiers de la politique. »

Le rêve du père Dubarle nous met sur la piste d’un dernier aspect important de la cybernétique : en plus de la régulation qui peut englober l’ensemble des comportement, jusqu’aux phénomènes collectifs de gouvernement, ce qui l’inquiète et le fascine ici est l’idée que cette régulation ou ce gouvernement puisse être effectué par des machines. Or, les machines qu’il a en tête, ce sont les machines à calculer, qui sont un peu l’obsession des cybernéticiens. À travers elles, c’est toute l’ontologie de l’information et d ela régulation qui foncitonne à plein, ainsi que l’idée, plus générale, selon laquelle machines et être vivants doivent être compris de le même façon : comme des automates qui traitent de l’information, poursuivent des buts et, éventuellement, sont capables d’apprentissage.

Voyons comment fonctionne cette analogie.

III. L’analogie cerveau-ordinateur

Auourd’hui, ce qu’on associe le plus au mot « cybernétique », c’est les nouvelles technologies et tout ce qui relève de l’informatique. C’est sans doute un abus de langage et un usage flou du mot mais c’est pas sorti de nulle part. Dans les participants aux conférences Macy qui forment le noyau de la cybernétique, tout le monde est relié de près ou de loin aux débuts de l’informatique et des premiers odrinateurs. Shannon, avant de pondre sa thérie de l’information, a travaillé sur la façon dont on pouvait effectuer des calculs grâce à des circuits éléectriques. Wiener, avnat la guerre, avait rendu un rapprt dans lequel tous les principes essentiels de l’informatique modernes existaient déjà. Von Neumann, le célèbre mathématicien, a activement participé à la construction du premier ordinateur entièrement éléctronique et la théorie des ordinateurs. Enfin, le dernier et le plus important de tous s’appelle W. McCulloch, qui était obsédé par l’idée que le cerveau fonctionnait comme une machine, et qu’on pouvait modéliser son fonctionnement de la même façon qu’un circuit électrique.

Des machines pour calculer

Mais avant de parler un peu plus de McCulloch et de l’apport du moment cybernétique, il est intéressant de prendre du recul sur l’idée de machine à calculer.

Norbert Wiener, donc le fondateur de la cybernétique, passe son temps à répéter que l’informatique et l’avèement des machines à calculer marque le début d’une nouvelle révolution industrielle. Selon lui, le marqueur important, c’est que des machines qui avaient permis de remplacer l’énergie musculaire (machine à vapeur) et qu’aujourd’hui des machines permettent de remplacer le calcul et certaines tâches logiques élémentaires. Voir le texte 20 :

« Peut-être serais-je en mesure d’éclaircir l’arrière-plan historique de la situation présente si je dis que la première révolution industrielle, celle des dark satanic mills, fut la dévaluation du bras humain par la concurrence de la machine. Le gagne-pain minimm d’un prolétaire américain ne sera jamais assez bas pour faire face au travail d’une excavatrice à vapeur. La révolution industrielle moderne est pareillement à même de dévaluer le cerveau humain, au moins dans ses décisions les plus simples et les plus routinières. Évidemment, tout comme le charpentier, le mécanicien et le tailleur qualifiés ont jusqu’à un certain point survécu à la première révolution industrielle, le scientifique et l’administrateur qualifiés devraient survivre à la seconde. Cependant, celle-ci accomplie, l’être humain moyen aux connaissances médiocres n’a plus rien à vendre qui vaille d’être rémunéré.

La solution, bien sur, est une société basée sur des valeurs humaines autres que l’achat ou la vente. Pour y parvenir, nous avons besoin de beaucoup de planification et de beaucoup de lutte »

Mais cette vision des choses a quelque chose d’un peu trop facilement progressiste. Je pense plutôt pour ma part que la machinisation est intrinsèque au capitalisme lui-même, comme on essaye par ailleurs de le montrer Marx dans Le Capital. Je ne rentre pas ici dans cet ouvrage mais je veux juste faire remarquer une chose. L’un des ancêtres souvent cité des machines à calculer s’appelle Charles Babbage.

Babbage (1792-1871), qui remplace Newton à la chaire de mathématiques de Cambridge : matheux, astronome, il a été aussi théoricien de la révolution industrielle (L’économie des manufactures et des machines, le chapitre 19 s’appelle « on the division of mental labour »). Babbage s’intéresse dans son chapitre sur le travail intellectuel à M. de Prony, un révolutionnaire français qui travaillait à l’établissement de tables de calculs trigonométriques et qui raconte que ça lui prenait beaucoup de temps. Sous la plume de Babbage (21) : « À peine avait-il parcouru les premières pages [de la richesse des Nations] que, par une espèce d’inspiration, il conçut l’expédient de mettre les logarithmes en manufactures comme les épingles » (97-98). De même que de Prony avait compris qu’on pouvait appliquer la division du travail aux calculs intellectuels, de même Babbage va un pas plus loin en disant qu’on peut donc les faire faire par des machines. Il raconte qu’il s’endormait devant des tables de logarithmes et qu’il rétorque à quelqu’un qui l’interpelle que ça devrait être fait par des machines.

Donc : c’est l’idée de réduire les tâches, de les diviser jusqu’à obtenir une tâche simple, qui permet ensuite de machiniser, c’est-à-dire effectuer en série des tâches simples. Or ce principe est énoncé au départ chez Smith et son principe de la main invisible. Et en un sens, tout fonctionne come ça dans le mode de production capitaliste : on prend un travail, ou une communauté, ou un raisonnement, on le démembre en unités élémentaires pour le rationaliser, puis on le machinise et enfin on réassemble le tout. Attention : ça ne veut pas dire qu’on simplifie les choses. On les simplifie peut-être à un moment mais pour mieux les remettre ensemble, et cette seconde opération peut générer des choses très compliquées.

Avant de passer au modèle qui m’intéresse, il faut rapidemment évoquer le contexte d’avant la guerre, qui va déboucher sur l’invention des machines à calculer modernes. Dans les années 30 les travaux de Gödel et de Turing sont les points de départ de l’informatique. Le théorème de Gödel (31), montre que pour tout système formel (un langage formel, des axiomes et des règles dans ce langage) suffisamment riche pour contenir une arithmétique, on a la proposition suivante : soit le système est inconsistant, soir il existe au moins une proposition indémontrable. Celle-ci n’est ni fausse ni vraie, elle est indécidable. Bon, je rentre pas dans les détails mais ce théorème a été assez important historiquement. Et surtout, il est à la source des travaux qui ont fait naître l’informatique. Comment ? Eh bien Gödel nous dit : il existe des thèses ou des théorèmes indémontrables dans tel système donné. Mais qu’est-ce qu’une formule démontrable ? C’est pas clair chez Gödel. Et c’est là que Turing intervient en 36-37 : non pas tant pour expliquer ce que c’est qu’une fonction démontrable ou calculable mais plutôt pour expliquer que toute fonction calculable est modélisable par une machine, qu’on appellera ensuite la machine de Turing, qui est un mécanisme relativement simple. Là encore, je ne détaille pas, on en reparlera peut-être demain.

Donc, pour faire simple, on perd la possibilité de tout démontrer (Gödel), mais on gagne l’idée que tout ce qui peut se calculer peut l’être par une machine. Je rentre pas plus loin là dedans car il y aurait beaucoup de choses à dire sur Gödel, Turing mais je ne les connais pas bien et ça nous amènerait bien ailleurs.

Des réseaux de neurones formels

Reste que ces machines seront réellement construites seulement plus tard, vers la seconde moitié du XXe siècle. Ce que vient apporter la cybernétique là-dedans, c’est la construction d’analogies entre le cerveau et l’ordinateur pour essayer de mieux comprendre l’un et l’autre. Ça va toujours dans les deux sens. L’autre article très important de naissance de la cybernétique dont je n’ai pas parlé date de 43 et est écrit par un neurologue, Warren McCulloch, l’un des personnages principaux de la cybernétique et son collègue logicien Walter Pitts. L’article s’appelle : « Un calculateur logique des idées immanentes dans l’activité nerveuse ».

Ils montrent qu’on peut considérer les neurones selon un schéma simplifié de « tout-ou-rien » : impulsion ou non. L’idée, c’est de ramener les neurones à un fonctionnement très simple. Il peuvent être activés ou non. Ils sont eux-mêmes conscients de la simplification : ils négligent par exemple toutes les relations chimiques, les variations plus fines dans les impulsions neuronales. Ils ne gardent que l’impulsion au sens vraiement électrique du mot. Le premier intérêt est très matériel : si on arrive à se représenter les neurones comme ça, on va pouvoir les incarner aussi dans des circuits électriques, à l’aide de résistances, de tubes à vides, etc. Le deuxième intérêt est logique et calculatoire : Pitts et McCulloch montrent qu’avec leur schéma on peut réaliser la plupart des opérations logiques de base (et, ou, non, etc) à l’aide de circuits de neurones.

Ici, je vais essayer de donner un exemple. Voici un schéma de base de ce à quoi ressemble un neurone formel, par opposition à un neurone réel :

Le neurone est réduit à des entrées et des sorties. Comment réalise-t-il une opération, un calcul ? Pitts et McCulloch font l’hypothèse que les neurones ont des seuils : ils ne se déclenchent que si un certain nombre d’autres neurones qui leur sont connectés se déclenchent aussi. Et donc on peut représenter par de tels neurones la fonction logique de conjonction, le « et », qui est l’une des opérations logiques de base. Par exemple, en reprenant le neurone ci-dessus, en disant que le neurone C ne se déclenche que s’il reçoit deux impulsions. Alors s’il se déclenche, on sait que A et B se sont aussi déclenchés.

Par contre, si le seuil du neurone est de 1, ie qu’il se déclenche dès qu’il reçoit une seule impulsion, alors il accomplit la fonction logique « Ou » : s’il se déclenche on sait que soit A, soit B s’est aussi déclenché.

Il peut aussi ne se déclencher en aucun cas et il va alors accomplir une sorte de négation : quoiqu’il arrive, il ne se déclenche pas.

Mon but en montrant ça n’est pas de vous prouver tout ça. Simplement d’indiquer l’ambition de Pitts et McCulloch, qui est énorme : montrer comment la pensée fonctionne matériellement, incarnée.

Enjeux et controverses

MacCulloch ne cesse de répéter qu’on est parvenu à percer le secret de l’esprit en quelques sortes, son assise matérielle et son fonctionnement. Il écrit (texte 23) :

« Pour la première fois dans l’histoire de la science, nous savons comment nous savons et nous pouvons ainsi l’expliquer clairement » – car « nous sommes sur le point de pouvoir nous représenter l’individu connaissant comme une machine à calculer ».

Il pense avoir montré avec son article que les neurones formels fonctionnent, au fond, comme des machines de Turing et son capables de résoudre n’importe quels problèmes logiques suffisament clairs.

Et sans doute là l’un des poids déterminant de la cybernétique et avec elle des neurosciences, comme l’écrit Erich Hörl (texte 24) :

« George Boole, dans son ouvrage fondamental sur les Lois de la pensée, avait bien fait un premier pas en direction d’une calculabilité des opérations mentales, amenée à devenir l’élément central d’une nouvelle « science de l’esprit ». Mais jusqu’à la fin des années 1930 et au début des années 1940, jusqu’à ce que l’émergence de la théorie de l’information physico-mathématique et son étroite alliance avec la neurophysiologie permette d’établir un parallèle exact entre les états d’une machine et les états de l’esprit, il était inconcevable que cette machine symbolique appelée « esprit » puisse être en tant que telle incorporée ou incorporable à des cerveaux et à des machines et que des calculs logiques puissent être reproductibles dans des circuits neuronaux ou électroniques. »

On pourrait en dire beaucoup sur cette nouvelle image de la pensée qui prend corps. En tous les cas, en la personne de McCulloch, il y a vraiment l’ambition d’éclaircir les ténèbres de la métaphysique (son article s’intitutle dans l’antre du métaphysicien), comme si, au fond, il reprenait le flambeau des lumières des mains de la philosophie. Non plus à partir de la métaphysique, mais à partir de la logique telle qu’elle s’incarne dans des circuits neuronaux et électriques.

Attention, les cybernéticiens ne sont pas tous d’accord sur tout ça : Von Neumann, par exemple, dit que le cerveau est plus compliqué, qu’on doit en rester à des analogies mais qu’en réalité il est fondamentalement différent de nos machines. Chez lui, il y a une attitude légèrement différente : il utilise les machines à calculer pour mieux comprendre le cerveau et inversement. Donc l’analogie doit nous aider à apprendre de l’un sur l’autre, mais il faut toujours se rappeler qu’elle n’est pas réelle. Il fait d’ailleurs des comparaisons assez dingues où il calcule le nombre de neurones, de relais électriques, leur vitesse, leur fiabilité, leur taille, etc.

C’est à Von Neuman, plus prudent sur l’association entre ordinateur et cerveau, que l’on doit la structure des premiers ordinateurs. Et il la tire des principes de la cybernétique : utiliser de l’information sous forme binaire ; retenir la programmation des machines dans une mémoire et sous la même forme binaire (on appelle ça l’architecture VN) ; appliquer le principe de contrôle ou de rétroaction aux calculs afin de minimiser les erreurs, etc. Je temrine là-dessus parce que ça permet de montrer comment tout fonctionne ensemble : l’information, la régulation et les ordinateurs font partie d’un nouveau système technique, d’une nouvelle manière d’aborder la pensée et le savoir en général qui font systèmes.

Conclusion

- Information, régulation, analogie ordinateur-cerveau

- Échec de la cybernétique ? Elle a échoué en plusieurs sens. Pas d’institutionalisation. Pas de résultats décisifs qui lui appartienne en propre, l’ordinateur dépassant la cybernétique (quelques prothèses). Pas de réelle théorie complète de la spiritualité, n’en déplaise à McCulloch. Et aussi, les vœux de wiener sont restés vains, qui voulait réguler l’automatisation des sociétés, questionner la pertinence du travail, ne pas servir les intérêts militaires, etc.

- Et en même, temps, grande diffusion des concepts : quelques exemples : biologie (code génétique, etc), linguistique, sciences cognitives, mais aussi certaines branches de l’écologie, de la science de systèmes, qui essaient notamment de voir comment les systèmes (biologiques, humaines, etc) s’auto-régulent.

- Et surtout, l’impression générale que notre époque est comme bloquée dans une boucle de feedback positif.

Plus de Exposé

La vraie vie

Novembre 2018

Exemplifier

Tout peut servir d’exemple. Donc il n’y a pas d’exemple en soi.

A première vue, l’exemple de quelque chose est là pour consolider l’existence d’autre chose, pour faire advenir son être, pour l’imposer. On dirait que l’exemple est de l’ordre de l’impur, de l’imparfait, dévoilant partiellement et imparfaitement une réalité qui lui est supérieure. L’exemple a une fonction de monstration, il fait signe vers autre chose qui est extérieure à lui-même.

Exposé

la vraie vie

novembre 2018

La vie bonne : genres et formes de vie dans la philosophie antique

Quand la philosophie apparaît au Ve siècle av. J.-C., elle ne naît pas comme science, mais comme mode de vie. Philosopher, c’est vivre un certain genre de vie et, si l’on en croit ceux qui le vivent, le meilleur parmi tous. La vie bonne, c’est la vie contemplative. Une telle affirmation s’appuie une réflexion plus large sur les formes de vie – qui ne se réduit ni à la biologie, ni à la sociologie, ni à l’anthropologie, mais qui se situe en

deçà du partage entre l’étude générale du vivant et celle de ses formes singulières. La philosophie n’est donc qu’une forme de vie parmi les autres, mais cette forme prétend être la plus haute. Il faut donc chercher à comprendre ce qui lie l’étude des formes de vie à un plaidoyer pour la vie philosophique. Si le mot grec theoria ne signifie pas simplement « théorie », c’est-à-dire un savoir coupé de l’expérience, mais « contemplation », c’est-à-dire un certain rapport vivant à ce qui est, alors il faut examiner en quoi ce rapport peut prétendre être plus vrai que les autres.

Exposé

La vraie vie

décembre 2018

Vie et vérité chez Nietzsche

Pour cette séance, on commencera par suivre le raisonnement de Nietzsche dans sa dimension destructrice. Ce dernier s’attaque en effet à tous les discours prétendument absolus – par exemple ceux de la philosophie ou de la religion – pour les ramener au type de vie qui l’énonce, en se demandant à chaque fois qui parle. Nietzsche est ainsi un des premiers auteurs à détruire la croyance en l’existence de vérités indépendantes de leur situation d’énonciation, et des rapports de pouvoir particuliers qui les caractérisent. Cette forme de nihilisme fait aujourd’hui partie de notre condition contemporaine : pourquoi choisir un mode de vie plutôt qu’un autre si toute croyance peut être réduite à une stratégie vitale ?

On verra ensuite comment Nietzsche tente de sortir de ce nihilisme. Pour cela, il lui faut reconstruire une distinction entre différentes existences plus ou moins authentiques, à l’intérieur d’un cadre où toute transcendance a été détruite. On examinera sa proposition, qui en passe entre autre par une opposition entre force et faiblesse, et on en questionnera les limites.